1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

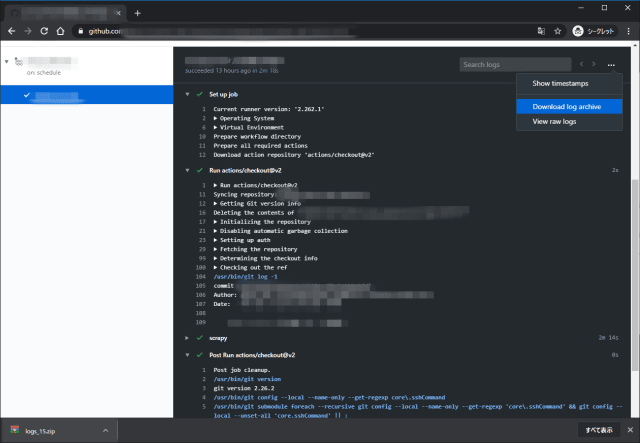

| 2020-05-18 XX:XX:XX [scrapy.core.engine] DEBUG: Crawled (404) <GET http://quotes.toscrape.com/robots.txt> (referer: None)

2020-05-18 XX:XX:XX [scrapy.core.engine] DEBUG: Crawled (404) <GET http://splash:8050/robots.txt> (referer: None)

2020-05-18 XX:XX:XX [scrapy_splash.middleware] WARNING: Bad request to Splash: {'error': 400, 'type': 'ScriptError', 'description': 'Error happened while executing Lua script', 'info': {'source': '[string "..."]', 'line_number': 7, 'error': 'Force Splash Error', 'type': 'LUA_ERROR', 'message': 'Lua error: [string "..."]:7: Force Splash Error'}}

2020-05-18 XX:XX:XX [scrapy.core.engine] DEBUG: Crawled (400) <GET http://quotes.toscrape.com/js/ via http://splash:8050/execute> (referer: None)

2020-05-18 XX:XX:XX [quotesjs] ERROR: <twisted.python.failure.Failure scrapy.spidermiddlewares.httperror.HttpError: Ignoring non-200 response>

2020-05-18 XX:XX:XX [quotesjs] ERROR: HttpError on http://quotes.toscrape.com/js/

2020-05-18 XX:XX:XX [scrapy.core.engine] INFO: Closing spider (Force Close!!!!!!)

2020-05-18 XX:XX:XX [scrapy.statscollectors] INFO: Dumping Scrapy stats:

{'downloader/request_bytes': 1282,

'downloader/request_count': 3,

'downloader/request_method_count/GET': 2,

'downloader/request_method_count/POST': 1,

'downloader/response_bytes': 1134,

'downloader/response_count': 3,

'downloader/response_status_count/400': 1,

'downloader/response_status_count/404': 2,

'elapsed_time_seconds': 2.439215,

'finish_reason': 'Force Close!!!!!!',

'finish_time': datetime.datetime(2020, 5, 18, xx, xx, xx, XXXXXX),

'log_count/DEBUG': 3,

'log_count/ERROR': 2,

'log_count/INFO': 10,

'log_count/WARNING': 2,

'memusage/max': 56270848,

'memusage/startup': 56270848,

'response_received_count': 3,

'robotstxt/request_count': 2,

'robotstxt/response_count': 2,

'robotstxt/response_status_count/404': 2,

'scheduler/dequeued': 2,

'scheduler/dequeued/memory': 2,

'scheduler/enqueued': 2,

'scheduler/enqueued/memory': 2,

'splash/execute/request_count': 1,

'splash/execute/response_count/400': 1,

'start_time': datetime.datetime(2020, 5, 18, 6, 5, xx, xx, xx, XXXXXX)}

2020-05-18 XX:XX:XX [scrapy.core.engine] INFO: Spider closed (Force Close!!!!!!)

|